Por Léo Vitor Utida

Nos posts anteriores, discutimos acerca da ideia do racismo enquanto parte estruturante de nossa sociedade e, em seguida, como isso em consequência implica na sua perenização mesmo nas ciências exatas, computacionais e algoritmos. Aqui, veremos como tais discriminações se concretizam e avaliaremos possibilidades e saídas desta encruzilhada.

MATERIALIZAÇÃO DO RACISMO ALGORÍTMICO E IMPLICAÇÕES

Ao apontarmos casos específicos, de forma alguma abarcamos a totalidade do problema. Muito mais que casos pontuais, é preciso compreender que desde o início da cadeia de produção — ou, neste caso, programação — as tecnologias digitais, altamente concentradas no Vale do Silício em um ínfimo número de empresas bilionárias, operam sob uma lógica de supremacia branca (SILVA, 2020). Isto não quer dizer, é claro, que aqueles e aquelas que programam sejam intencionalmente racistas, mas parte da compreensão do racismo enquanto estruturante da sociedade e, portanto, da subjetividade e ideologia. Como afirmado anteriormente nos outros posts, não é necessário que haja intencionalidade para que o racismo seja materializado. Entretanto, acreditamos que seja necessário observar como se concretiza tais discriminações para que, somente assim, tenhamos uma mínima noção dos problemas e possamos iniciar uma reflexão a respeito. Dessa forma, vamos analisar inicialmente um caso que repercutiu nas redes sociais recentemente:

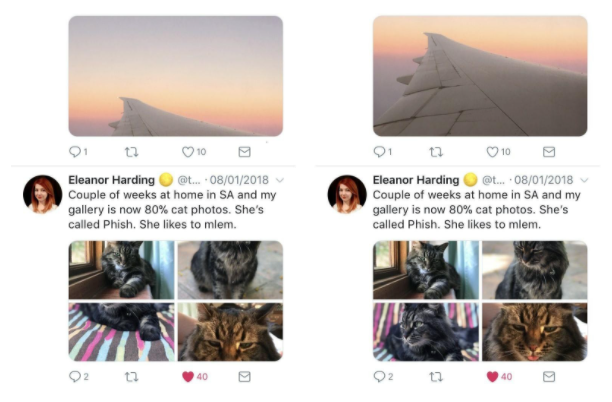

À esquerda, antes do algoritmo: o recorte automaticamente focava o centro da imagem. À direita, o novo algoritmo: o recorte determina a área de maior saliência.

A partir de 2018, o Twitter implementou um algoritmo de recorte inteligente de imagens que não sejam retangulares na horizontal — pois esta é a proporção da visualização de imagens no site, podendo o usuário ver a imagem completa ao clicar nela. Até então, o que ficaria em destaque na visualização era o centro da imagem, tendo, a partir da adoção deste novo algoritmo, passado a se destacar a área cuja própria empresa chamou de maior “saliência” (5): região da imagem com maiores chances das pessoas olharem. Uma rede neural foi treinada a partir de machine learning para prever qual região deveria ser destacada.

A partir disto, uma equipe devidamente diversa e qualificada já poderia prever problemas que surgiriam disto, tendo em vista os conceitos de racismo estrutural e conteúdos anteriormente abordados. Entretanto, em setembro de 2020, um programador e usuário do site decidiu pôr o algoritmo à teste.

À esquerda, o tweet testando o algoritmo. À direita, as imagens inteiras publicadas.

O usuário publicou duas imagens, na qual apareciam um senador estadunidense branco na parte superior da imagem e, na parte inferior, o ex-presidente dos Estados Unidos Barack Obama que, como sabemos, é negro, sendo a outra imagem apenas uma inversão das posições dos políticos. Em ambas as imagens, o algoritmo privilegiou o homem branco, mesmo que seja notório saber a importância e fama global de Obama.

O caso levantou um grande debate e discussão dentro do próprio site, com vários usuários testando variações, com outras personalidades, fundos coloridos, fotos nos quais os negros estavam sorrindo, maior luminosidade e outras infinidades de possibilidades. Entretanto, em praticamente todos os casos, o resultado era o mesmo: a pessoa branca era privilegiada pelo algoritmo, recebendo destaque no recorte automático.

~

Não é nossa intenção nos estender e prolongar em casos específicos, como já dito anteriormente. Há uma outra imensidão de ocorrências que podemos citar, como o algoritmo do Google Fotos categorizando pessoas negras como “gorilas” (7), a deteção facial das câmeras Nikon falhando em reconhecer rostos asiáticos (8), registros de dispenser automático de sabonete não reconhecendo mãos negras (9), filtros “embelezadores” do Snapchat embranquecendo pessoas racializadas (10) e tantas outras. Ainda assim, abordamos apenas uma ponta aparente do iceberg ao comentar tais casos.

No site de Tarcízio Silva, pesquisador brasileiro renomado quando se trata deste tema, há uma linha do tempo (11) onde diversos casos são enumerados e brevemente explicados, caso haja interesse em compreender melhor como tais ocorrências se dão.

CONSIDERAÇÕES FINAIS

Para a finalização a esta série de posts, no entanto, partimos para outra indagação: uma base de dados para o treinamento destes, seria uma solução efetiva? Ou, afinal, tratando-se de um problema estrutural, não seria correto dizer que o “defeito” está na sociedade e não nos algoritmos?

É preciso compreender que tal argumento tecnoliberal não se sustenta na medida em que o entendimento do racismo estrutural é dado. Isto é, aquelas e aqueles que programa não podem se escusar de seu papel no combate da reprodução do racismo e tomar atitudes efetivamente antirracistas sob um véu de uma suposta neutralidade e jogar a responsabilidade nas estruturas, quando se está ciente do racismo presente nelas:

pensar o racismo como parte da estrutura não retira a responsabilidade individual sobre a prática de condutas racistas e não é um álibi para racistas. Pelo contrário: entender que o racismo é estrutural, e não um ato isolado de um indivíduo ou de um grupo, nos torna ainda mais responsáveis pelo combate ao racismo e aos racistas. Consciente de que o racismo é parte da estrutural social e, por isso, não necessita de intenção para se manifestar, por mais que calar-se diante do racismo não faça do indivíduo moral e/ou juridicamente culpado ou responsável, certamente o silêncio o torna ética e politicamente responsável pela manutenção do racismo. (ALMEIDA, 2018, p. 40)

Nesse sentido, como ainda diz o mesmo autor Silvio Almeida (2018), é preciso que pessoas racializadas estejam presentes em todas as instâncias, instituições e partes de processos e cadeias produtivas, de programação, criação ou o que seja. Afinal, a experiência que tais corpos sofreram ao longo de suas vidas certamente fazem com que estes carreguem pontos de vistas que possibilitam a percepção de detalhes que outros corpos, normativos, não perceberiam. Não surpreendentemente, um estudo da Universidade de Stanford revelou que, nos Estados Unidos, pessoas negras e mulheres ainda têm muita dificuldade de adentrar espaços acadêmicos e, mesmo quando entram, ganham pouco destaque e atenção, mesmo quando suas pesquisas são consideradas inovadoras ou relevantes. No Brasil, a cena se repete pois apenas 2,7% dos alunos de pós-graduação são negros e 2% amarelos, sendo menos de 1% indígena (SANTOS, 2020). Isso explica, ainda que parcialmente, porque problemas e vieses que podem soar óbvios para alguns, ainda passam despercebidos por muitos.

Ainda mais agravante, é preciso considerar que o pacto da branquitude também teme e rejeita a possibilidade da perda de seus privilégios, que invariavelmente são garantidos pela violação da dignidade e por agressões — e, aqui, não necessariamente físicas — ao corpo racializado. Timinit Gebru, cientista da computação renomada mundialmente por suas pesquisas e trabalhos a respeito da ética da inteligência artificial e racialidade, foi recentemente demitida injustificadamente da Google (12) após denunciar que seus superiores queriam força-la a desistir de um artigo acadêmico que estava escrevendo a respeito de assuntos que a empresa “não estava pronta para debater”.

Assim, esta série de posts não se coloca com a finalidade de esgotar a discussão, muito pelo contrário, serve apenas como uma breve introdução a um assunto tão complexo e profundo que não pode ser simplificado, ainda mais quando relacionado a toda a estrutura social que sustenta nosso sistema de produção e vida. Dessa forma, esperamos ter fomentado, mesmo que um pouco, reflexões críticas acerca dos algoritmos que se fazem cada vez presentes em nossas vidas, que poderiam levar a ainda outras discussões tão complexas quanto, a respeito da influência em nossas tomadas de decisões e privacidade de dados. Ao longo dos posts, referências e links foram dados para maior aprofundamento caso haja o interesse. Agradecemos a leitura de todes.

(5) A explicação em maiores detalhes dada pela própria empresa pode ser vista em: https://blog.twitter.com/engineering/en_us/topics/infrastructure/2018/Smart-Auto-Cropping-of-Images.html

(7) https://bits.blogs.nytimes.com/2015/07/01/google-photos-mistakenly-labels-black-people-gorillas/

(8) http://content.time.com/time/business/article/0,8599,1954643,00.html

(9) https://gizmodo.com/why-cant-this-soap-dispenser-identify-dark-skin-1797931773

(10) https://www.buzzfeed.com/br/krishrach/as-pessoas-acham-que-os-filtros-de-beleza-do-snapc

(11) https://tarciziosilva.com.br/blog/posts/racismo-algoritmico-linha-do-tempo

(12) https://brasil.elpais.com/tecnologia/2020-12-13/por-que-a-demissao-de-pesquisadora-negra-do-google

-se-transformou-em-escandalo-global.html

REFERÊNCIAS

SILVA, Tarcízio. Racismo algorítimico em plataformas digitais: microagressões e discriminação em código. In: SILVA, Tarcízio. Comunidades, algoritmos e ativismos digitais: olhares afrodiaspóricos. São Paulo: LiteraRUA, 2020. p. 120-137. Disponível em:

https://www.academia.edu/42254259/Comunidades_Algoritmos_e_Ativismos_olhares_afrodiasporicos

SANTOS, Robson. Paradoxo na ciência:: negros e mulheres inovam, mas são raros na academia. negros e mulheres inovam, mas são raros na academia. 2020. Disponível em:

https://www.uol.com.br/tilt/noticias/redacao/2020/09/16/paradoxo-na-ciencia-inovadores-negros-e-mulheres-sao-raros-na-academica.htm